Vision Language là gì? Khi AI “nhìn” và “hiểu” thế giới như con người

Mô hình ngôn ngữ thị giác (Vision language model) là sự kết hợp tiên tiến giữa thị giác máy tính (Computer Vision) và xử lý ngôn ngữ tự nhiên (NLP). VLM giúp máy tính hiểu và tạo văn bản mô tả hình ảnh, kết nối hiệu quả giữa dữ liệu hình ảnh và ngôn ngữ. Bài viết này sẽ giới thiệu về Vision Language Model, ứng dụng thực tế, tầm quan trọng và cách triển khai mô hình ngôn ngữ thị giác.

1. Vision Language là gì?

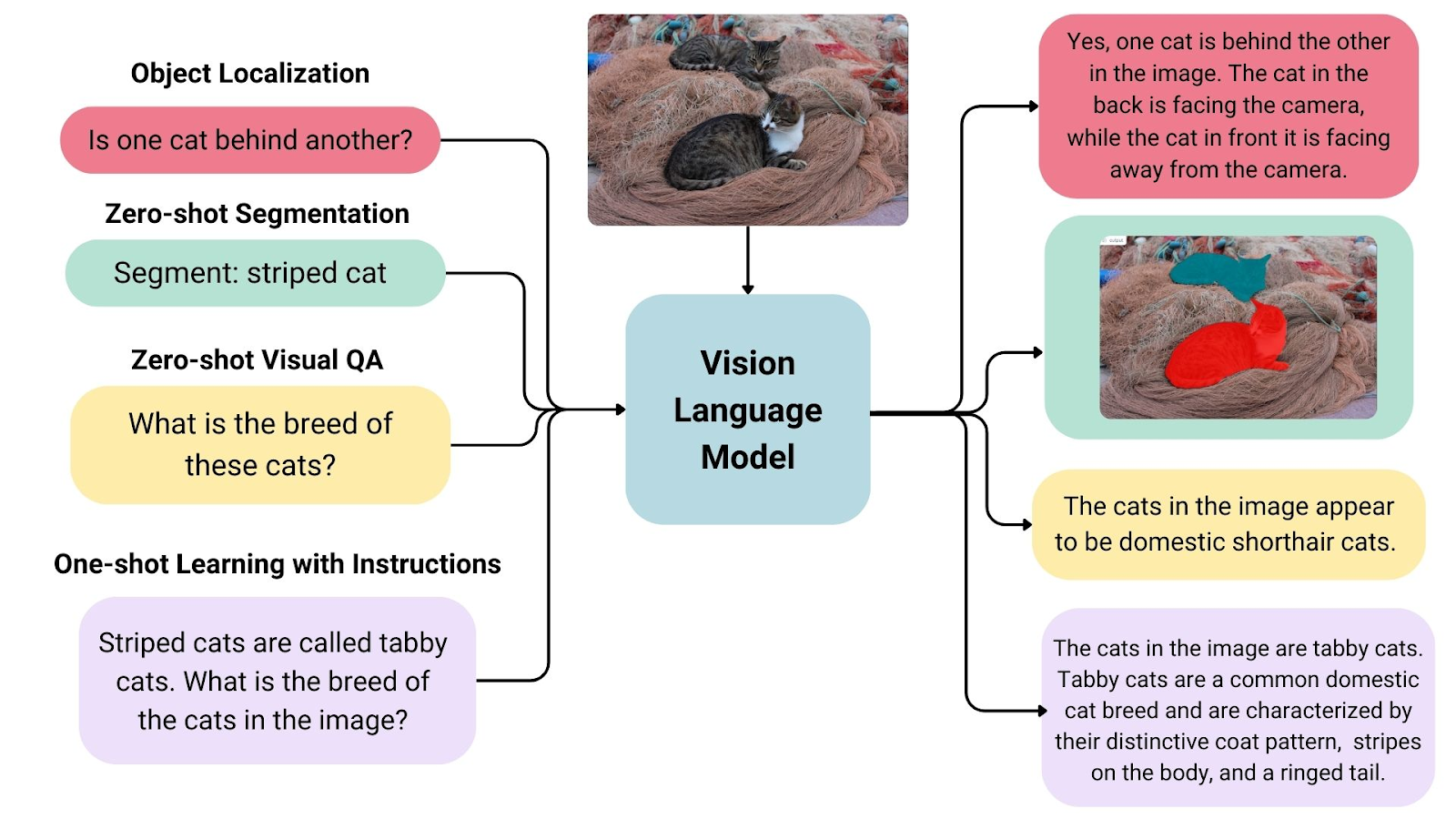

Ngôn ngữ thị giác (Vision Language) là một lĩnh vực Trí tuệ nhân tạo (AI) đang phát triển nhanh, kết hợp Thị giác máy tính (Computer Vision) và Xử lý ngôn ngữ tự nhiên (NLP). Mô hình ngôn ngữ thị giác được thiết kế để hiểu mối quan hệ giữa hình ảnh và văn bản, giúp chúng có thể “nhìn” và “đọc” thông tin từ thế giới xung quanh. Những mô hình này đặc biệt hữu ích trong các lĩnh vực đòi hỏi cả 2 nguồn dữ liệu: hình ảnh và chữ viết.

Một số ứng dụng của Mô hình:

- Nhận diện và mô tả hình ảnh (Image understanding): Xác định và phân loại đối tượng trong ảnh, hỗ trợ tự động tạo chú thích.

- Hiểu tài liệu số (Document understanding): Nhận diện ký tự quang học (OCR) để trích xuất nội dung từ ảnh/tài liệu

- Xử lý biểu mẫu và biểu đồ phức tạp (Complex OCR and chart understanding): Đọc và phân tích các bảng biểu, sơ đồ, biểu đồ có cấu trúc phức tạp.

- Liên kết hình ảnh và ngữ nghĩa (Visual grounding & reasoning): Xác định mối liên kết giữa các yếu tố trực quan và văn bản liên quan, giúp trả lời câu hỏi dựa trên dữ liệu hình ảnh.

So với OCR (chỉ nhận diện chữ trong ảnh) hay Object Detection (chỉ phát hiện và khoanh vùng vật thể), Vision Language có thể được coi là bao gồm cả 2 lĩnh vực này, cho phép xử lý thông tin toàn diện hơn. Điều này giúp tối ưu hóa các tác vụ như tìm kiếm thông tin, số hóa tài liệu, hỗ trợ chatbot, và nhiều ứng dụng khác trong thực tế.

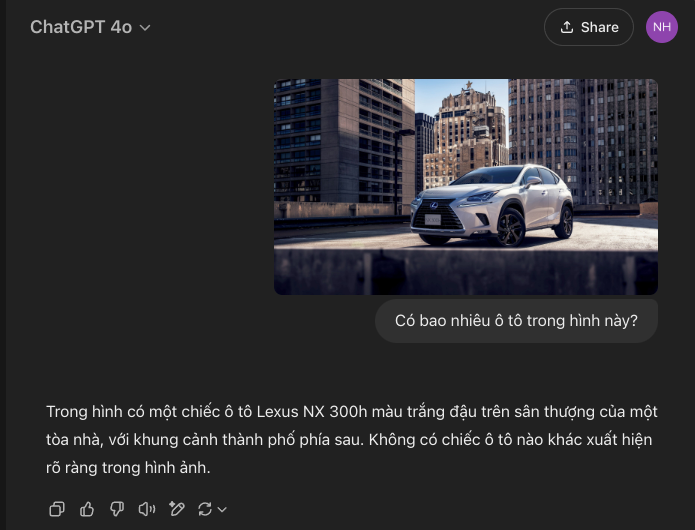

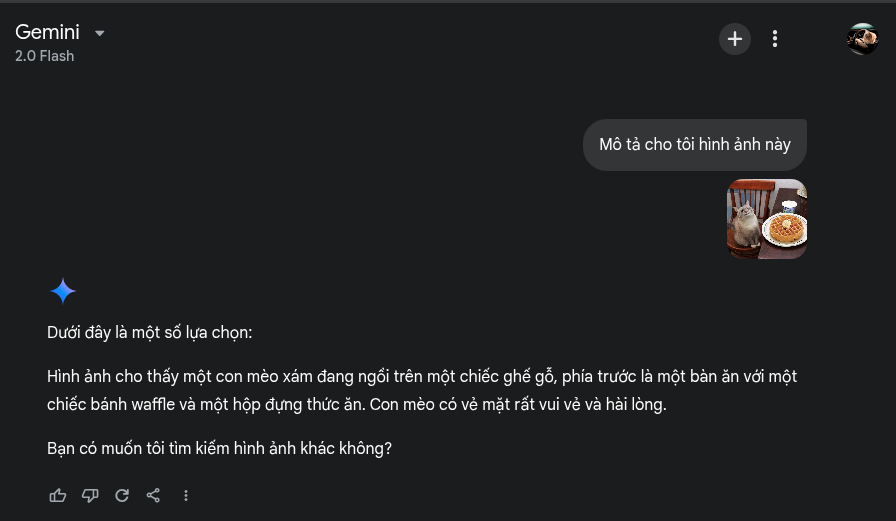

Vision Language model xác định sự liên kết giữa hình ảnh những chú mèo và câu hỏi để giúp đưa ra câu trả lời . Nguồn ảnh: Hugging face

Đọc thêm: AI Agent là gì? Khám phá “tác nhân AI” từ A-Z

2. Ứng dụng thực tế của mô hình ngôn ngữ thị giác

Mô hình ngôn ngữ thị giác (Vision Language Model) không chỉ là một công cụ công nghệ mà còn mở ra nhiều tiềm năng ứng dụng thực tế trong thương mại điện tử, du lịch, nông nghiệp, giáo dục, tiếp thị và quảng cáo.

2.1. Thương mại điện tử (E-commerce)

- Tìm kiếm sản phẩm bằng hình ảnh: Cho phép khách hàng tìm kiếm sản phẩm bằng ảnh thay vì nhập từ khóa, đặc biệt hữu ích cho các mặt hàng có hoa văn, kết cấu hoặc thiết kế độc đáo.

- Thử đồ ảo: Giúp người dùng thử quần áo, trang điểm, phụ kiện trực tiếp trên ảnh của họ, mang lại trải nghiệm mua sắm tiện lợi hơn.

- Gợi ý sản phẩm cá nhân hóa: Phân tích hình ảnh sản phẩm khách hàng đã xem hoặc mua để đề xuất các lựa chọn phù hợp hơn.

- Tự động gắn thẻ sản phẩm: Sử dụng mô hình ngôn ngữ thị giác để gắn thẻ từ khóa liên quan cho sản phẩm, giúp tối ưu hóa công cụ tìm kiếm và nâng cao trải nghiệm khách hàng.

2.2. Du lịch

- Hướng dẫn du lịch trực quan: Các ứng dụng du lịch có thể sử dụng hình ảnh và video để cung cấp thông tin chi tiết về các điểm tham quan, văn hóa, ẩm thực địa phương. Với Vision language model, người dùng chỉ cần chụp ảnh một địa điểm và nhận ngay thông tin chi tiết về lịch sử, các hoạt động gợi ý hoặc hướng dẫn viên ảo.

- Đề xuất du lịch cá nhân hóa: Bằng cách phân tích hình ảnh mà du khách quan tâm hoặc chụp lại trong các chuyến đi trước, VLM có thể đề xuất những điểm đến hoặc hoạt động phù hợp với sở thích của họ.

- Dịch thuật thời gian thực: Một trong những thách thức lớn đối với khách du lịch quốc tế là rào cản ngôn ngữ. VLM có thể hỗ trợ dịch các biển báo, thực đơn, tài liệu hoặc bất kỳ văn bản nào xuất hiện trong ảnh, giúp du khách dễ dàng di chuyển và trải nghiệm địa điểm du lịch hơn.

2.3. Nông nghiệp:

- Phát hiện bệnh cây trồng: Đào tạo vision language model để xác định bệnh cây trồng từ hình ảnh cây trồng, cho phép can thiệp sớm và cải thiện năng suất cây trồng. Điều này đặc biệt có liên quan đến Việt Nam, một nước xuất khẩu nông sản lớn các loại cây trồng như gạo và cà phê.

- Phân loại cây trồng tự động: Sử dụng VLM để tự động phân loại và sắp xếp cây trồng dựa trên kích thước, hình dạng và chất lượng, giúp giảm chi phí lao động và cải thiện hiệu quả.

2.4. Giáo dục:

- Tài liệu học tập tương tác: Tạo tài liệu học tập hấp dẫn sử dụng hình ảnh, video kết hợp với văn bản để giải thích các khái niệm một cách trực quan, hỗ trợ giảng dạy các môn học như khoa học, lịch sử, địa lý.

2.5. Tiếp thị và quảng cáo:

- Tạo nội dung: Sử dụng VLM để tự động tạo chú thích, tiêu đề, nội dung mô tả tự động cho hình ảnh/video, giúp doanh nghiệp dễ dàng xây dựng nội dung hấp dẫn cho mạng xã hội, website và quảng cáo.

- Quảng cáo có mục tiêu: Phân tích hình ảnh mà người dùng quan tâm để hiển thị quảng cáo phù hợp, giúp các thương hiệu tiếp cận đúng đối tượng khách hàng tiềm năng.

3. Xây dựng mô hình Vision Language như nào?

Bước đầu tiên để xây dựng vision language model là chuẩn bị bộ dữ liệu. Bộ dữ liệu gồm các cặp đôi gồm 1 ảnh và 1 văn bản. Ảnh có thể có nhiều kích thước rộng x dài (pixel) khác nhau, hầu hết nằm trong 640×480 pixel đến 1920×1080 pixel. Văn bản có thể là 1 đoạn văn miêu tả ảnh đó hoặc 1 cặp câu hỏi câu trả lời liên quan đến ảnh đó. Độ dài văn bản cũng linh hoạt như trong bộ dữ liệu cho các mô hình ngôn ngữ lớn. Để tăng độ đa dạng cho bộ dữ liệu, những bộ dữ liệu cho các nhiệm vụ như Image Classification, OCR, Object Detection … có thể tái sử dụng. Bời vì đầu ra của những nhiệm vụ này là số, tên, và chữ, … cũng thuộc phạm trù văn bản. Nguồn của bộ dữ liệu ảnh-văn bản thường được lấy từ những trang web có ảnh thuyết minh (Wikipedia). Những đội của các công ty lớn có thể tự tổng hợp bằng tay kết hợp tự động hóa với cộng đồng tạo dữ liệu (crowdsourcing). Một vài ví dụ đang tiêu biểu là Google Wikipedia-based Image Text (37 triệu cặp ảnh-văn bản trong 100 ngôn ngữ), HuggingFaceM4/OBELICS (141 triệu văn bản, 353 triệu ảnh), LAION-5B (2.3 tỷ cặp trong tiếng Anh, 2.2 tỷ cặp trong 26 ngôn ngữ khác).

Những bài viết trên Wikipedia thường có ảnh minh họa đi kèm với chú thích

Trong cộng đồng khoa học máy, có những cá nhân (HuggingFace/dinhanhx) và tập thể (HuggingFace/5CD-AI) sử dụng Google Dịch hoặc ChatGPT để dịch bộ dữ liệu từ tiếng Anh sang tiếng Việt, mặc dù không hoàn hảo nhưng vẫn có sự đóng góp cho tiếng Việt. Những bộ dữ liệu này đã được công bố trong các link HuggingFace profile.

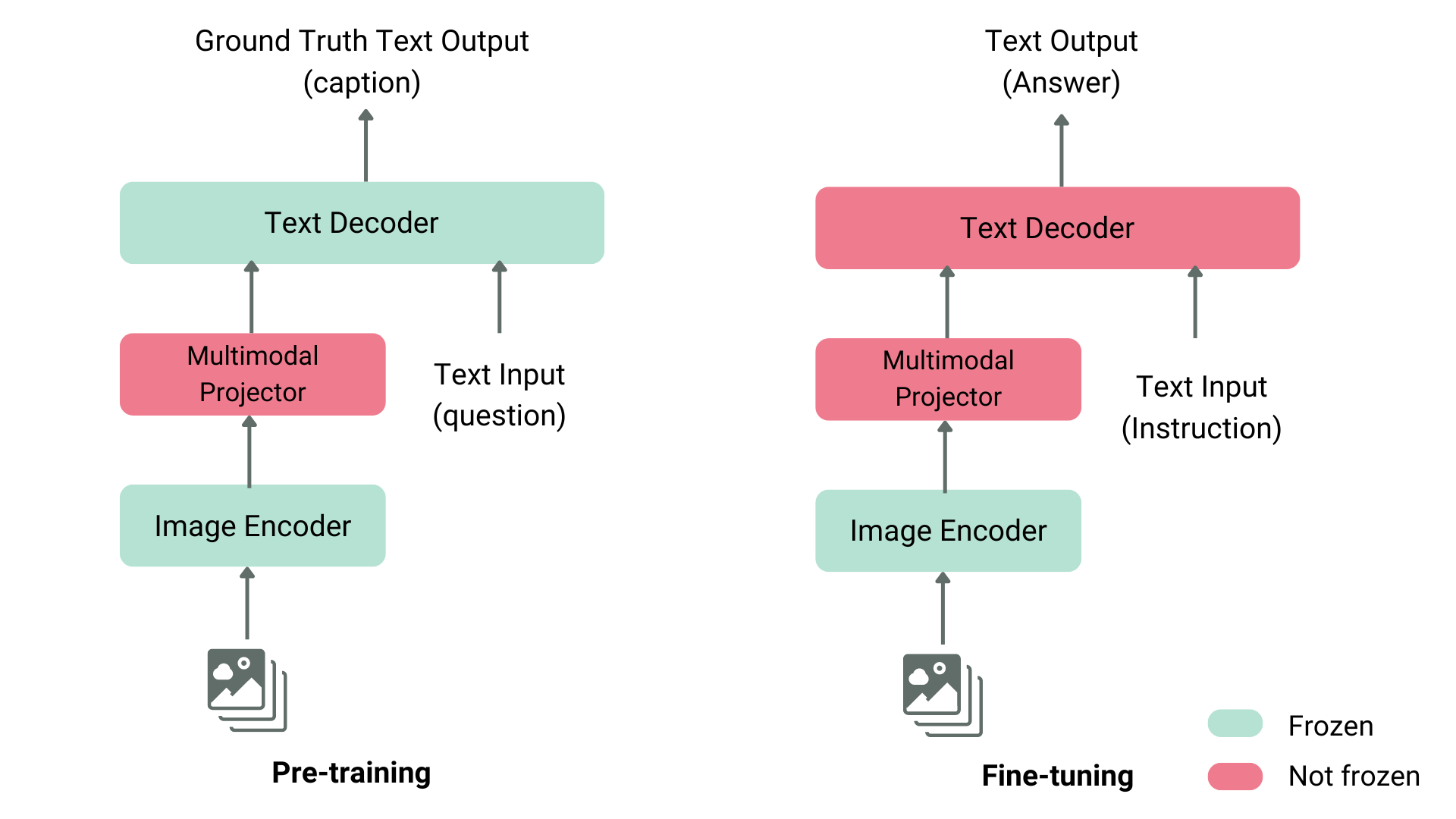

Bước thứ hai là thiết kế và huấn luyện. Một mô hình sẽ gồm 2 phần, Image Encoder và Text Decoder (như hình minh họa ở dưới). Image Encoder còn được đến là Image Feature Extraction, Image Backbone, Image Representation trong Computer Vision. Text Decoder thường là mô hình ngôn ngữ trong NLP. Những mô hình này có thể đã được tiền huấn luyện (Pretrain) bằng các dữ liệu thuần ảnh (cho Image model), và thuần chữ (cho Text model). Cách huấn luyện Vision Language Model sẽ tương tự (nhưng không dễ hơn) cách huấn luyện LLM. Bởi vì LLM chỉ thuần chữ, còn VLM sẽ phải chuyển thể (projector) từ ảnh sang các token hoặc các vector mà Text Decoder có thể hiểu được. Về mặt thuật toán, VLM phức tạp hơn LLM. Điều này đồng nghĩa với việc yêu cầu phần cứng có thể phải nhanh hơn hoặc to hơn.

Thiết kế tiêu biểu và các bước huấn luyện cho mô hình

Bước thứ ba cũng là bước cuối, kiểm tra và đo khả năng thực hiện trên các bộ dữ liệu kiểm chuẩn chẳng hạn Crossmodal 3600. Công đoạn này cho người đào tạo mô hình một cái nhìn khác quan.

4. Sử dụng mô hình Vision Language như nào?

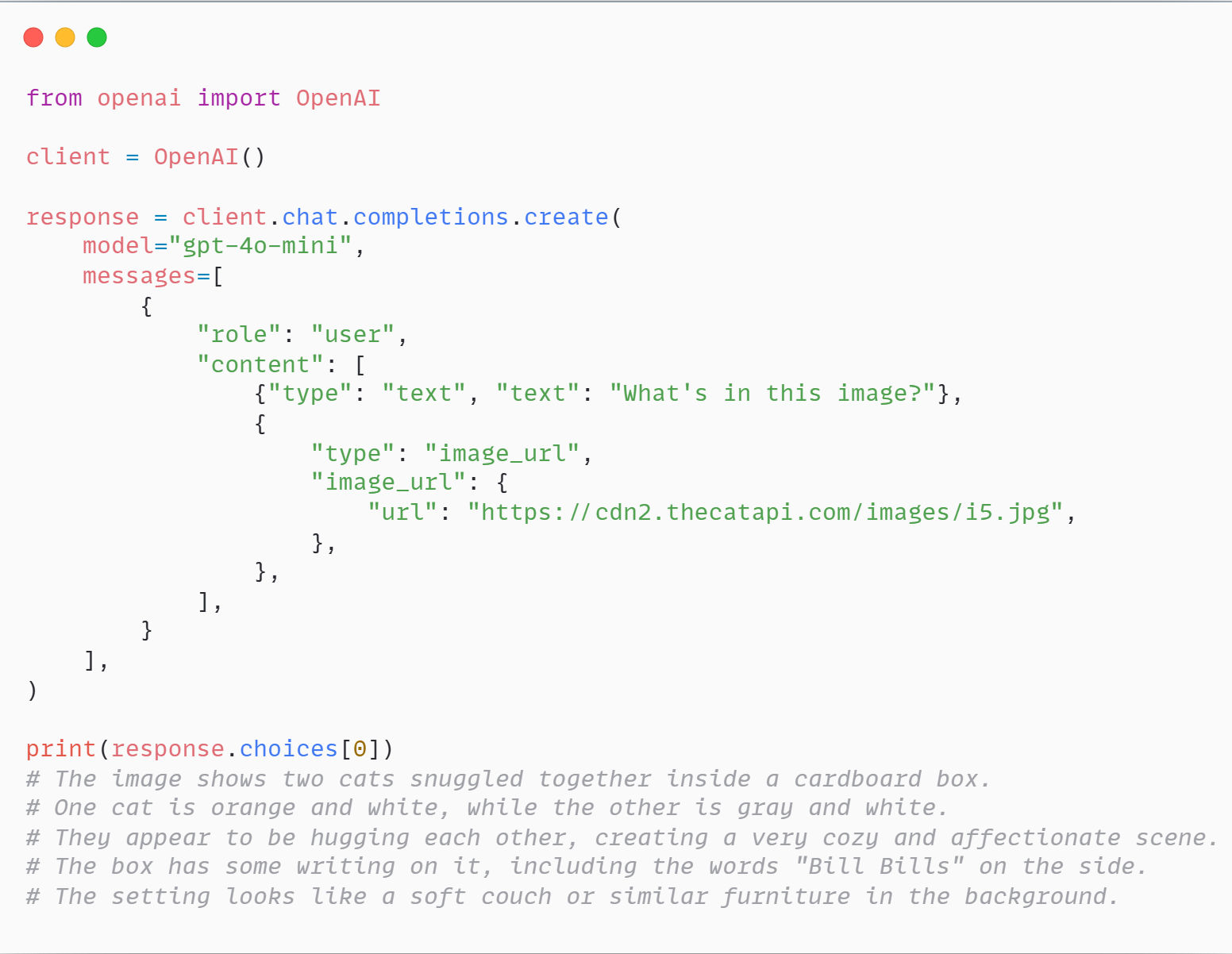

Những người dùng thường thức có thể truy cập miễn phí những mô hình GPT-4o, Gemini 2.0 Flash được cung cấp bởi OpenAI, Google. Đối với lập trình viên, OpenAI API Platform, Google AI Studio, Nvidia Build Platform cho phép sử dụng các mô hình qua API đám mây để tích hợp vào các dự án sẵn có. Những nền tảng này cũng có những SDK (dễ cài và dễ bắt đầu) trong những ngôn ngữ phổ biến như Python, Javascript, C#. Một ví dụ là OpenAI Python SDK.

Source code ví dụ sử dụng OpenAI Python SDK để diễn tả 1 hình ảnh về mèo bằng tiếng Anh. Plain text của source code

Tùy vào đặc thù của dự án, nếu sử dụng API đám mây không được chấp nhận (phải đặt tại cơ sở), lập trình viên có thể sử dụng các mô hình mã nguồn mở như: Qwen/Qwen2.5-VL-72B-Instruct , meta-llama/Llama-3.2-90B-Vision-Instruct. Để cho công việc thuận tiện hơn nữa, những công cụ vLLM, LMDeploy, SGLang để triển khai những mô hình (vừa được liệt kê). Những công cụ này hoàn toàn tương thích OpenAI Python SDK. Nếu dự án yêu cầu mô hình gần gũi với tiếng Việt, một mô hình đáng quan tâm là 5CD-AI/Vintern-1B-v3_5. Yêu cầu phần cứng (chủ yếu GPU) của những mô hình này cũng tương tự như các mô hình thuần ngôn ngữ lớn. Những GPU thường được mua và lưu hành là cách dòng của NVIDIA: A100, H100, B100,…

Hình ảnh thực tế sử dụng GPT-4o

Hình ảnh thực tế trải nghiệm Gemini 2.0 Flash

Kết luận

Vision Language Model đánh dấu một bước tiến quan trọng trong lĩnh vực trí tuệ nhân tạo, giúp máy tính không chỉ “nhìn” mà còn “hiểu” và “diễn giải” hình ảnh một cách trực quan hơn bao giờ hết. Tương lai của VLM hứa hẹn sẽ tiếp tục phát triển mạnh mẽ, với những cải tiến vượt bậc về độ chính xác, tốc độ xử lý và tính ứng dụng thực tế. Những doanh nghiệp và tổ chức sớm áp dụng công nghệ này sẽ có lợi thế lớn trong việc nâng cao khả năng cạnh tranh và tạo ra những giá trị đột phá trong kỷ nguyên AI.

Tài liệu tham khảo

- Khám phá biên giới của các mô hình Vision Language: Khảo sát về các phương pháp hiện tại và định hướng trong tương lai https://arxiv.org/abs/2404.07214

- Mô hình Vision Language là gì? https://www.nvidia.com/en-us/glossary/vision-language-models/

- Giải thích mô hình Vision Language https://huggingface.co/blog/vlms

- Khả năng thị giác Llama https://www.llama.com/docs/how-to-guides/vision-capabilities/

| Bài viết độc quyền bởi Chuyên gia công nghệ FPT IS

Anh Vũ Đinh Anh Thạc Sĩ Khoa Học Máy Tính, Kỹ sư AI tại Trung tâm nghiên cứu và phát triển trí tuệ nhân tạo FPT IS (FPT IS AI R&D Center) |