Generative AI đáng tin cậy đối với chuyển đổi kinh doanh bền vững

Tiếp cận AI tạo sinh (Generative AI)

Mỗi ngày, các phương tiện truyền thông đều xôn xao với những tin tức về những tiến bộ đột phá của AI tự sinh. Nghiên cứu của chúng tôi cũng ủng hộ quan điểm rằng AI tự sinh có khả năng mang lại giá trị kinh tế hàng nghìn tỷ mỗi năm. Nhưng, chúng ta không nên lãng quên bài học từ các cuộc cách mạng công nghệ trước đây như internet, điện thoại di động và mạng xã hội, nơi mà niềm hứng khởi ban đầu thường phải nhường chỗ cho thách thức trong việc khai thác giá trị kinh doanh thực sự. Sự bùng nổ của AI tự sinh hiện nay tạo ra một cơ hội không thể bỏ qua để chúng ta áp dụng những bài học kinh nghiệm này, biến những lời hứa về AI tạo sinh thành những giá trị kinh doanh bền vững.

Khi nói về chiến lược phát triển những khả năng của AI tạo sinh, một số những quyết định thường thấy như “thuê, mua hoặc tạo dựng” được nêu lên. Quy tắc cơ bản vẫn được giữ nguyên: đầu tư vào khả năng của AI tạo sinh để tạo ra lợi thế độc quyền cho doanh nghiệp và sử dụng những dịch vụ đang có cho những thứ tương tự với hàng hoá hơn.

Các công ty có thể cân nhắc tính ứng dụng của ba ví dụ nguyên mẫu dưới đây:

- Taker – sử dụng những mô hình công khai khả dụng thông qua giao diện trò chuyện hoặc API, không cần hoặc chỉ cần tuỳ chỉnh rất ít. Các ví dụ điển hình bao gồm các giải pháp sẵn có để tạo mã (chẳng hạn như GitHub Copilot) hoặc hỗ trợ các designer tạo và chỉnh sửa hình ảnh (chẳng hạn như Adobe Firefly). Đây là nguyên mẫu đơn giản nhất xét về cả nhu cầu kỹ thuật và cơ sở hạ tầng. Nhìn chung đây là nguyên mẫu có thể được thiết lập và vận hành nhanh nhất. Về cơ bản, những mô hình này là những mặt hàng cần dựa vào việc feeding data dưới dạng lời nhắc vào mô hình đại chúng.

- Shaper – tích hợp mô hình với dữ liệu và các hệ thống nội bộ để tạo ra kết quả được tuỳ chỉnh hơn. Ví dụ, một mô hình hỗ trợ các giao dịch bán hàng bằng cách kết nối các công cụ của AI tạo sinh với CRM và các hệ thống tài chính để tích hợp lịch sử bán hàng và tương tác của khách hàng. Một ví dụ khác là tinh chỉnh mô hình bằng tài liệu nội bộ của công ty và lịch sử chat để hỗ trợ nhân viên chăm sóc khách hàng. Khuôn mẫu “Shaper” phù hợp với những công ty đang mong muốn mở rộng khả năng của AI tạo sinh, phát triển năng lực độc quyền, hoặc đáp ứng nhu cầu bảo mật hay tuân thủ cao hơn.

Trong khuôn mẫu này, có hai cách thức thông dụng để tích hợp dữ liệu với mô hình AI tạo sinh. Cách thứ nhất là “đưa mô hình đến dữ liệu”, tức là mô hình được lưu trữ trên cơ sở hạ tầng của tổ chức, dù là trên máy chủ riêng hay trên môi trường đám mây. Ví dụ, Cohere triển khai mô hình cơ sở trên cơ sở hạ tầng đám mây của khách hàng, giảm bớt nhu cầu chuyển dữ liệu. Cách thức thứ hai là “đưa dữ liệu đến mô hình”, nơi tổ chức có thể tổng hợp dữ liệu của mình và triển khai bản sao của mô hình lớn trên cơ sở hạ tầng đám mây. Cả hai cách thức này đều đạt được mục tiêu cung cấp quyền truy cập vào mô hình cơ sở, và việc lựa chọn giữa chúng sẽ phụ thuộc vào khối lượng công việc của tổ chức.

- Maker – xây dựng một mô hình nền tảng để giải quyết một trường hợp riêng biệt. Xây dựng một mô hình nền tảng rất tốn kém và phức tạp, yêu cầu một lượng lớn dữ liệu, chuyên môn sâu và khả năng tính toán mạnh mẽ. Lựa chọn này cần đầu tư khá lớn trong một lần , con số lên tới hàng chục hoặc hàng trăm triệu đô để xây dựng và đào tạo mô hình này. Chi phí sẽ phụ thuộc vào rất nhiều yếu tố, ví dụ như cơ sở hạ tầng để đào tạo, lựa chọn kiến trúc cho mô hình, số lượng thông số mô hình, kích thước dữ liệu, và các nguồn lực chuyên môn.

Mỗi khuôn mẫu sẽ có chi phí riêng mà các nhà lãnh đạo công nghệ cần cân nhắc. Mặc dù sự tiến bộ liên tục, như các phương pháp đào tạo mô hình hiệu quả và giảm chi phí tính toán đơn vị xử lý đồ họa (GPU) theo thời gian, đang giúp giảm chi phí, nhưng độ phức tạp của khuôn mẫu “Maker” cho thấy rằng hầu hết các tổ chức sẽ áp dụng sự kết hợp giữa “Taker” và “Shaper” (để nhanh chóng tiếp cận dịch vụ hàng hóa, và để xây dựng năng lực độc quyền trên mô hình cơ sở), ít nhất là trong tương lai gần.

Generative AI tại những điểm chạm kinh doanh

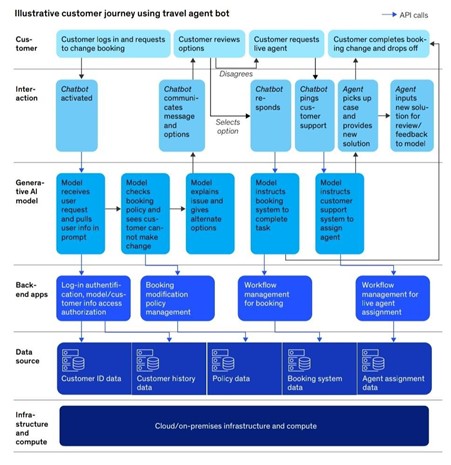

Khi các tổ chức vạch ra lộ trình của mình trong lĩnh vực AI tạo sinh đang ngày càng phát triển, họ cần phải nhận ra phạm vi đa dạng của các mô hình đang hoạt động, sự khác biệt về quy mô, độ phức tạp và khả năng. Các tổ chức sẽ sử dụng nhiều mô hình AI tạo sinh với quy mô, độ phức tạp và khả năng khác nhau. Để có thể tạo ra giá trị, các mô hình này cần có khả năng hoạt động cùng với nhau và với các hệ thống hoặc ứng dụng hiện có của doanh nghiệp. Chính vì lý do này, việc xây dựng Tech Stack riêng cho AI tạo sinh sẽ tạo ra nhiều phức tạp hơn là giải quyết. Ví dụ, khi một người khách hàng hỏi về dịch vụ khách hàng tại một công ty du lịch để giải quyết vấn đề đặt chỗ, mô hình AI tạo sinh cần truy cập vào nhiều ứng dụng và nguồn dữ liệu.

Trong khi nguyên mẫu Taker vận hành mà không cần phải có sự phối hợp bổ sung, các công ty đang mong muốn mở rộng các lợi ích của AI như là một Shaper hoặc Maker cần trải qua một cuộc đại tu công nghệ dưới sự dẫn dắt của CIOs và CTOs. Mục tiêu chính ở đây là tích hợp mô hình AI tạo sinh một cách liền mạch vào các hệ thống nội bộ và các ứng dụng hiện có của doanh nghiệp, thiết lập nên những đường dẫn tới những nguồn dữ liệu phong phú. Cuối cùng, sự trưởng thành trong kiến trúc công nghệ của doanh nghiệp mới chính là chìa khoá để tích hợp và mở ra khả năng của AI tạo sinh.

Những bước tiến gần đây trong tích hợp và orchestration framework được minh hoạ qua LangChain và LlamaIndex đã hợp lý hoá quá trình kết nối nhiều mô hình AI tạo sinh với các ứng dụng và các nguồn dữ liệu khác. Nhiều khuân mẫu tích hợp đang dần xuất hiện nhiều hơn, trong đó có cả những mẫu cho phép các mô hình có thể gọi API khi phản hồi các yêu cầu truy vấn thông tin của người dùng – được minh hoạ qua chức năng gọi của GPT-4. Ngoài ra, còn có một kĩ thuật được biết đến là “retrieval augmented generation” (kết hợp của thành phần truy xuất thông tin (Retrieval) với mô hình tạo sinh văn bản (Generation)), trong đó dữ liệu theo ngữ cảnh đến từ những tập dữ liệu ngoài luồng được cung cấp như là một phần trong yêu cầu truy vấn thông tin của người dùng.

Lãnh đạo công nghệ đóng vai trò chủ chốt trong việc xác định các kiến trúc tham khảo và các khuôn mẫu tích hợp tiêu chuẩn cho tổ chức của họ. Điều này bao gồm việc thiết lập định dạng API tiêu chuẩn, các thông số xác định được người dùng và mô hình để gọi API. Đây là những nỗ lực then chốt trong việc đảm bảo sự tích hợp AI tạo sinh một cách mượt mà và tạo tiền đề cho việc mở rộng quy mô hiệu quả trong hệ sinh thái kinh doanh.

Với nền tảng tổ chức này, ngày càng rõ ràng rằng các khả năng của riêng Mô hình Ngôn ngữ Lớn (LLM) có thể sẽ không đủ để xử lý những tình huống phức tạp trong thế giới thực. Trong phần khám phá tiếp theo, chúng tôi sẽ đi sâu vào những hạn chế hiện có của LLM, làm sáng tỏ nhu cầu về cách tiếp cận toàn diện hơn để giải quyết các tình huống và xác định những gì doanh nghiệp có thể thực hiện để tận dụng khả năng học hỏi của con người về công nghệ có tiềm năng to lớn này.

Generative AI đáng tin cậy

ChatGPT, Gemini hay bất cứ LLM nào đều không đủ

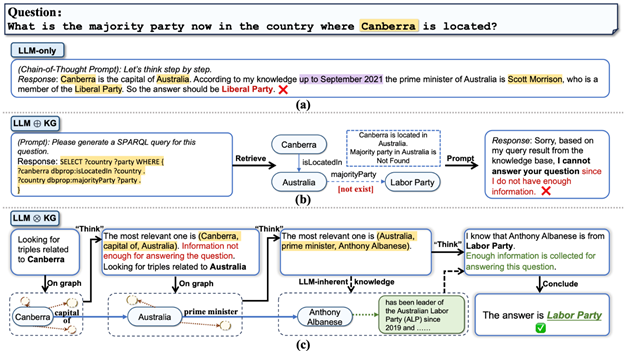

Dù LLM đã đạt được nhưng thành công nhất định, họ vẫn phải vật lộn với các vấn đề về hallucination, đặc biệt là trong các tình huống đòi hỏi suy luận sâu và có trách nhiệm. Điển hình là ChatGPT và LLaMAcó khả năng xử lý ngôn ngữ tự nhiên tiên tiến, khả năng mã hóa/giải mã văn bản mạnh mẽ và khả năng suy luận phát sinh. Các mô hình này được thiết kế chủ yếu để xử lý văn bản, tuy nhiên các tình huống trong thế giới thực thường liên quan đến dữ liệu văn bản đan xen với thông tin được cấu trúc ở dạng biểu đồ (ví dụ: mạng lưới học thuật và thương mại điện tử). Ngược lại, có những trường hợp dữ liệu biểu đồ được làm phong phú bằng các chi tiết văn bản (ví dụ: mô tả phân tử). LLM cũng phải đối mặt với những thách thức lớn trong các nhiệm vụ suy luận kiến thức phức tạp. Những thách thức này bao gồm sự thiếu chính xác trong việc trả lời các câu hỏi đòi hỏi kiến thức chuyên môn, những hạn chế trong việc xử lý chuỗi logic dài và lý luận nhiều bước, thiếu trách nhiệm, khả năng giải thích và tính minh bạch cũng như tính chất tốn kém và tốn thời gian của quá trình đào tạo. Những hạn chế này nhấn mạnh sự cần thiết của các phương pháp tiếp cận đổi mới hơn, chẳng hạn như sự tích hợp các biểu đồ tri thức bên ngoài, để nâng cao khả năng và giải quyết những thiếu sót của LLM.

Những biểu đồ kiến thức – nguồn đáng tin cậy

Để giải quyết những thách thức này, chúng tôi tin rằng cách tiếp cận tốt nhất là sử dụng kết hợp LLM – Biểu đồ tri thức (KG), ký hiệu là “LLM – KG”. Mô hình này coi LLM như một tác nhân để khám phá các thực thể và mối quan hệ trên KG, tận dụng kiến thức bên ngoài để lập luận. Phương pháp được đề xuất được gọi là Think-on-Graph (ToG) đang triển khai mô hình này. ToG yêu cầu LLM lặp đi lặp lại việc thực hiện tìm kiếm chùm trên KG, khám phá các đường dẫn lý luận đầy hứa hẹn và trả về các kết quả có khả năng xảy ra nhất. Một số thử nghiệm được thiết kế kỹ càng đã chứng minh những ưu điểm của ToG, bao gồm khả năng suy luận sâu được cải tiến so với LLM truyền thống, khả năng truy xuất nguồn gốc kiến thức và khả năng sửa lỗi. ToG cũng cung cấp một khung mẫu plug-and-play linh hoạt cho các LLM, KG khác nhau và thúc đẩy các chiến lược mà không phải trả thêm chi phí đào tạo. Điều thú vị là hiệu suất của ToG với các mô hình LLM nhỏ lại vượt trội hơn so với các mô hình lớn hơn như GPT-4 trong một số trường hợp nhất định, giúp giảm thiểu chi phí triển khai.

Nhận thức được những thách thức này, sự kết hợp kiến thức bên ngoài như biểu đồ tri thức (KG) nhằm cải thiện lý luận LLM là một giải pháp tự nhiên và đầy hứa hẹn. KG cung cấp các cách trình bày kiến thức có cấu trúc, rõ ràng và có thể chỉnh sửa, đó là một chiến lược bổ sung để có thể giảm thiểu những hạn chế của LLM. Các nhà nghiên cứu đã khám phá ra việc sử dụng KG làm nguồn kiến thức ngoài luồng để giảm thiểu hiện tượng hallucination trong LLM. Các cách tiếp cận này tuân theo một quy trình: truy xuất thông tin từ KG, bổ sung dữ liệu vào lệnh đề nghị, và đưa dữ liệu mở rộng vào LLMs. Trong bài viết này, chúng tôi gọi mô hình này là “LLM ⊕ KG”. Mặc dù nhằm mục đích tích hợp sức mạnh của LLM và KG, nhưng trong mô hình này, LLM đóng vai trò là người phiên dịch chuyển các câu hỏi đầu vào thành lệnh mà máy có thể hiểu được để KG tìm kiếm và suy luận, nhưng nó không tham gia trực tiếp vào quá trình suy luận biểu đồ. Tuy nhiên, mô hình LLM ⊕ KG vẫn có những hạn chế riêng và sự thành công của nó phụ thuộc rất nhiều vào tính hoàn chỉnh và chất lượng cao của KG.

Trong một nghiên cứu kết hợp gần đây được thực hiện bởi IDEA Research, Đại học Xiamen, Đại học Southern California, Đại học Khoa học và Công nghệ Hồng Kông và Microsoft Research Asia, các tác giả Jiashuo Sun, Chengjin Xu và các đồng nghiệp đã đề xuất một mô hình mới “LLM ⊗ KG” trong đó KG và LLM có liên kết chặt chẽ, hoạt động song song, bổ trợ nhau trong từng bước suy luận biểu đồ. Hình 1c là ví dụ minh họa ưu điểm của LLM ⊗ KG, trong đó mối quan hệ bị thiếu “majority party” dẫn đến lỗi trong Hình 1b có thể được bổ sung bằng bộ ba tham chiếu được phát hiện bởi tác nhân LLM với khả năng suy luận động, cũng như thành viên đảng chính trị của Anthony Albanese đến từ kiến thức vốn có của LLM . Bằng cách này, LLM thành công trong việc tạo ra câu trả lời đúng với kiến thức đáng tin cậy được lấy từ KG. Khi ứng dụng mô hình này, một khung thuật toán được ra đời với tên gọi “Think-on-Graph” (nghĩa là: LLM “suy nghĩ” dọc theo các lộ trình lý luận “trên” kiến thức “đồ thị” từng bước, viết tắt là ToG. ToG cho phép LLM linh hoạt khám phá một số đường dẫn suyluận trong KG và đưa ra quyết định tương ứng. Khi có một câu hỏi đầu vào, trước tiên ToG xác định các thực thể ban đầu và sau đó gọi LLM lặp đi lặp lại để truy xuất các bộ ba có liên quan từ các KG thông qua khám phá (tìm kiếm các bộ ba có liên quan trong KG thông qua bước “trên biểu đồ”) và lý luận (quyết định các bộ ba phù hợp nhất thông qua bước “suy nghĩ”) cho đến khi thu thập được thông tin đầy đủ thông qua đường lý luận top-N trong tìm kiếm chùm để trả lời câu hỏi (được đánh giá bởi LLM trong bước “Suy nghĩ”) hoặc đạt đến độ sâu tìm kiếm tối đa đã được xác định trước.

Lợi ích của phương pháp này có thể được tóm tắt như sau:

- Lý luận sâu: Trích xuất các đường dẫn lý luận đa dạng và nhiều bước nhảy từ Biểu đồ tri thức (KG), làm nền tảng cho Mô hình ngôn ngữ lớn (LLM) để nâng cao khả năng lý luận sâu. Điều này đặc biệt có lợi cho các nhiệm vụ đòi hỏi kiến thức sâu.

- Lý luận có trách nhiệm: Cung cấp các đường dẫn lý luận rõ ràng và có thể chỉnh sửa, góp phần nâng cao khả năng giải thích của quy trình lý luận của LLM. Cải tiến này cho phép truy tìm và hiệu chỉnh các nguồn đầu ra của mô hình, đảm bảo việc ra quyết định có trách nhiệm và minh bạch.

- Tính linh hoạt và Hiệu suất:

-

- Hoạt động như một khung plug-and-play, có khả năng thích ứng liền mạch với nhiều LLM và KG khác nhau.

- Trong khuôn khổ này, việc cập nhật kiến thức có thể được thực hiện thường xuyên thông qua KG, mang lại giải pháp thay thế hiệu quả hơn so với việc cập nhật kiến thức chậm và tốn kém trong LLM.

- Không chỉ cung cấp một framework linh hoạt mà còn tăng cường khả năng của các LLM nh hơn (ví dụ: LLAMA2-70B) để cạnh tranh hiệu quả với các đối tác lớn hơn như GPT-4 bằng cách nâng cao khả năng suy luận của chúng thông qua các đường dẫn lý luận top-N trong thuật toán tìm kiếm chùm.

Kiến thức đáng tin cậy – con đường dẫn tới thành công

Trong bối cảnh phức tạp của vô vàn sự đổi mới và xáo trộn, vai trò của Think-on-Graph (ToG) trong việc nâng cao Mô hình ngôn ngữ lớn (LLM) càng trở nên rõ ràng hơn. Sức mạnh tổng hợp giữa LLM và Biểu đồ tri thức (KG) không chỉ vượt qua những thách thức về giới hạn lý luận mà còn thể hiện một cách tiếp cận hướng tới tương lai để khai thác sức mạnh của kiến thức doanh nghiệp.

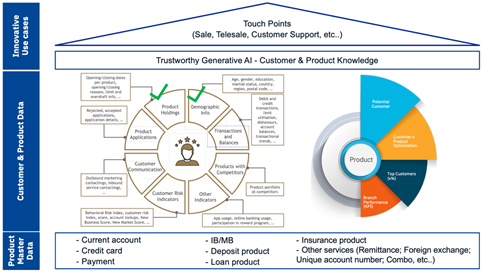

Trong thế giới số ngày nay, để chèo chống vượt qua những con sóng nguy hiểm của sự đổi mới và xáo trộn, kiến thức doanh nghiệp là nguồn nhiên liệu thúc đẩy tăng trưởng doanh nghiệp, là lá chắn ngăn ngừa rủi ro và là la bàn dẫn đường đến thành công. Tại sao kiến thức doanh nghiệp lại quan trọng đến vậy? Rất đơn giản: Kiến thức đáng tin cậy chính là sức mạnh. Kiến thức trao quyền cho nhân viên trong việc đưa ra quyết định sáng suốt, giải quyết vấn đề nhanh chóng và đổi mới một cách dũng cảm. Kiến thức củng cố thương hiệu doanh nghiệp bằng cách đảm bảo chất lượng ổn định và sự hài lòng của khách hàng. Nó thậm chí còn hoạt động như một pháo đài vô hình, bảo vệ tài sản trí tuệ và lợi thế cạnh tranh của chúng ta. Chỉ có kiến thức thôi là chưa đủ mà còn phải khai thác, trau dồi và làm cho mọi người trong tổ chức có thể tiếp cận nó một cách dễ dàng. Đó là lúc việc xây dựng Customer Insight phát huy tác dụng.

Hãy coi nó như một kho lưu trữ an toàn, không ngừng phát triển và chứa mọi thứ có giá trị trong doanh nghiệp của bạn:

- Khách hàng 360 độ: Thấu hiểu được nhu cầu, sở thích và điểm yếu của khách hàng trong lòng bàn tay.

- Best practices: Ghi lại và chia sẻ các quy trình làm việc, chiến lược và phương pháp hoạt động đã được thử nghiệm.

- Chuyên môn ngành: Luôn dẫn đầu bằng cách nắm bắt xu hướng thị trường, phân tích đối thủ cạnh tranh và các công nghệ mới nổi.

- Kiến thức : Gìn giữ lượng kiến thức dày dạn kinh nghiệm trước khi nó bị trôi đi.

- Lịch sử bán hàng và dịch vụ: Biến những thành công và thất bại trong quá khứ thành những bài học quý giá cho những dự án kinh doanh trong tương lai.

Tuy nhiên việc xây dựng một hệ thống như vậy yêu cầu một sự chuyển đổi trong lối tư duy. Chúng ta không chỉ dừng lại ở việc chỉ tích trữ các thông tin kín mà cần tăng cường việc hợp tác chia sẻ tri thức. Sự chuyển đổi này cần dựa vào ba cột chính:

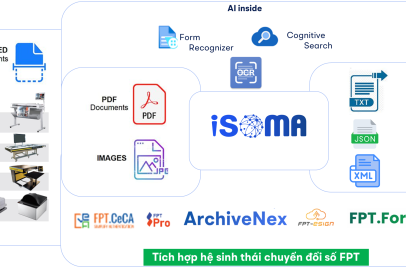

- Xây Dựng Cơ Sở Dữ Liệu Kiến Thức (Building the Ark): Nền tảng của bất cứ một hệ thống tri thức mạnh mẽ nào đều là một kho lưu trữ toàn diện, và dễ điều hướng. Nó cần dễ dàng tích hợp những hình thái đa dạng của thông tin – từ tài liệu, báo cáo, bản thuyết trình, cho đến video hay những bản thu âm lời khuyên của chuyên gia. Các chức năng tìm kiếm trực quan và hệ thống gắn thẻ (tagging) rất quan trọng để có thể truy xuất dễ dàng.

- Nuôi Dưỡng Văn Hóa Đóng Góp (Fostering a Culture of Contribution) Việc khuyến khích các nhân viên chủ động đóng góp kiến thức của họ là tối quan trọng. Hệ thống gamification và khen thưởng có thể khuyến khích sự tham gia còn các hội thảo chia sẻ kiến thức và chương trình cố vấn có thể thúc đẩy tạo nên một môi trường hợp tác. Hãy nhớ rằng, kiến thức chỉ thực sự có giá trị khi nó được lưu chuyển tự do.

- Liên Tục Cải Tiến (Continuous Improvement): Giống như bất kỳ một sinh vật sống nào, hệ thống kiến thức doanh nghiệp của bạn cần được nuôi dưỡng để phát triển. Kiểm toán và đánh giá hiệu suất định kỳ sẽ đảm bảo thông tin vẫn còn phù hợp và chính xác. Phản hồi của người dùng có thể mang đến những cái tiến giúp cho hệ thống luôn phù hợp với nhu cầu ngày càng tăng.

Kết luận

Hãy nhớ rằng, Generative AI đáng tin cậy của bạn là một thực thể sống. Hãy nuôi dưỡng nó bằng cách liên tục thêm vào những kiến thức mới, cập nhật thêm những thông tin hiện có và giữ cho chúng phù hợp và dễ dàng truy cập. Đừng để nó trở thành một kho lưu trữ bụi bặm;hãy khiến nó trở thành trái tim của tổ chức, bơm vào tổ chức những tri thức đến từng mạch máu và trao cho toàn bộ team của bạn khả năng đạt đến tầm cao mới.

Trong một thế giới nơi dữ liệu thường bị bỏ rơi nhưng sự hiểu biết thì hiếm có, việc tạo dựng một két sắt tri thức riêng cho doanh nghiệp không còn xa xỉ, mà nó là một sự cấp thiết. Vậy nên hãy bắt đầu mở những cánh cửa, giải phóng sức mạnh của tri thức, và chứng kiến công ty của bạn bay cao.

Ghi chú của tác giả:

Trong quá trình phát triển bài viết này, tôi đã tổng hợp các ý tưởng và khái niệm từ nhiều nguồn học thuật khác nhau để đưa ra một phân tích cô đọng và toàn diện. Cuộc thảo luận sau đây dựa trên các nghiên cứu của [Baig, et al] (McKinsey Digital 2023), [Sun, et al] (THINK-ON-GRAPH 2023), và [Luo, et al] (REASONING ON GRAPHS 2023), và một số những người khác. Những nguồn này đã đóng góp đáng kể vào khung lý thuyết và sự hiểu biết được trình bày trong bài viết này.

Sơ lược nhanh về các thuật ngữ chính:

Generative AI là một dạng AI có thể tạo dựng nội dung mới (như chữ, code, ảnh, và video) sử dụng các mẫu đã được học từ nguồn dữ liệu rộng (công cộng) cùng những kỹ thuật máy học (ML)

Mô hình nền tảng – Foundation model (FM) là những mô hình học chuyên sâu được đào tạo qua số lượng lớn những dữ liệu không có cấu trúc và không được phân loại mà có thể được sử dụng cho nhiều nhiệm vụ khác hoặc được điều chỉnh cho phù hợp với các nhiệm vụ cụ thể thông qua việc tinh chỉnh. Ví dụ về các mẫu này là GPT-4, PaLM 2, DALL·E 2 và Khuếch tán ổn định.

Các mô hình ngôn ngữ lớn (LLM) tạo thành một lớp mô hình nền tảng có thể xử lý số lượng lớn văn bản không có cấu trúc và tìm hiểu mối quan hệ giữa các từ hoặc các phần của từ, được gọi là token. Điều này cho phép LLM tạo văn bản bằng ngôn ngữ tự nhiên, thực hiện các tác vụ như tóm tắt hoặc trích xuất kiến thức. Cohere Command là một loại LLM; LaMDA là LLM đứng sau Bard.

Tinh chỉnh (Fine-tuning) là quá trình điều chỉnh mô hình nền tảng đã được huấn luyện trước để hoạt động tốt hơn trong một nhiệm vụ cụ thể. Điều này đòi hỏi một khoảng thời gian đào tạo tương đối ngắn trên tập dữ liệu được gắn nhãn, tập này nhỏ hơn nhiều so với tập dữ liệu mà mô hình được đào tạo ban đầu. Quá trình đào tạo bổ sung này cho phép mô hình tìm hiểu và thích ứng với các sắc thái, thuật ngữ và mẫu cụ thể có trong tập dữ liệu nhỏ hơn.

Xây dựng prompt đề cập đến quá trình thiết kế, tinh chỉnh và tối ưu hóa các prompt đầu vào để hướng dẫn mô hình AI tổng quát hướng tới việc tạo ra các đầu ra mong muốn (ở đây nghĩa là sự chính xác).

Bài viết độc quyền bởi Chuyên gia công nghệ FPT IS

Lê Việt Thanh

Phó Giám đốc Trung tâm Phân tích Dữ liệu và Nền tảng, FPT IS.